Google AI Overview, tính năng tóm tắt kết quả tìm kiếm mới của Google, đang gặp phải không ít vấn đề về “ảo giác” (hallucination) – hiện tượng AI tạo ra thông tin không có thật. Vấn đề mới nhất và đáng chú ý nhất là khả năng đáng kinh ngạc của nó trong việc gán ý nghĩa sâu sắc, thậm chí là biến các câu từ hoàn toàn vô nghĩa thành những thành ngữ hoặc tục ngữ có vẻ hợp lý. Đây là một ví dụ điển hình cho thấy những thách thức lớn về độ tin cậy mà AI đang phải đối mặt.

Google AI Overview: “Bậc Thầy” Giải Thích Thành Ngữ Giả Tạo

Nếu bạn thử nhập một câu ngẫu nhiên nghe có vẻ giống thành ngữ hoặc tục ngữ vào Google Search, AI Overview sẽ cố gắng hết sức để gán một ý nghĩa nào đó cho những từ ngữ trống rỗng của bạn.

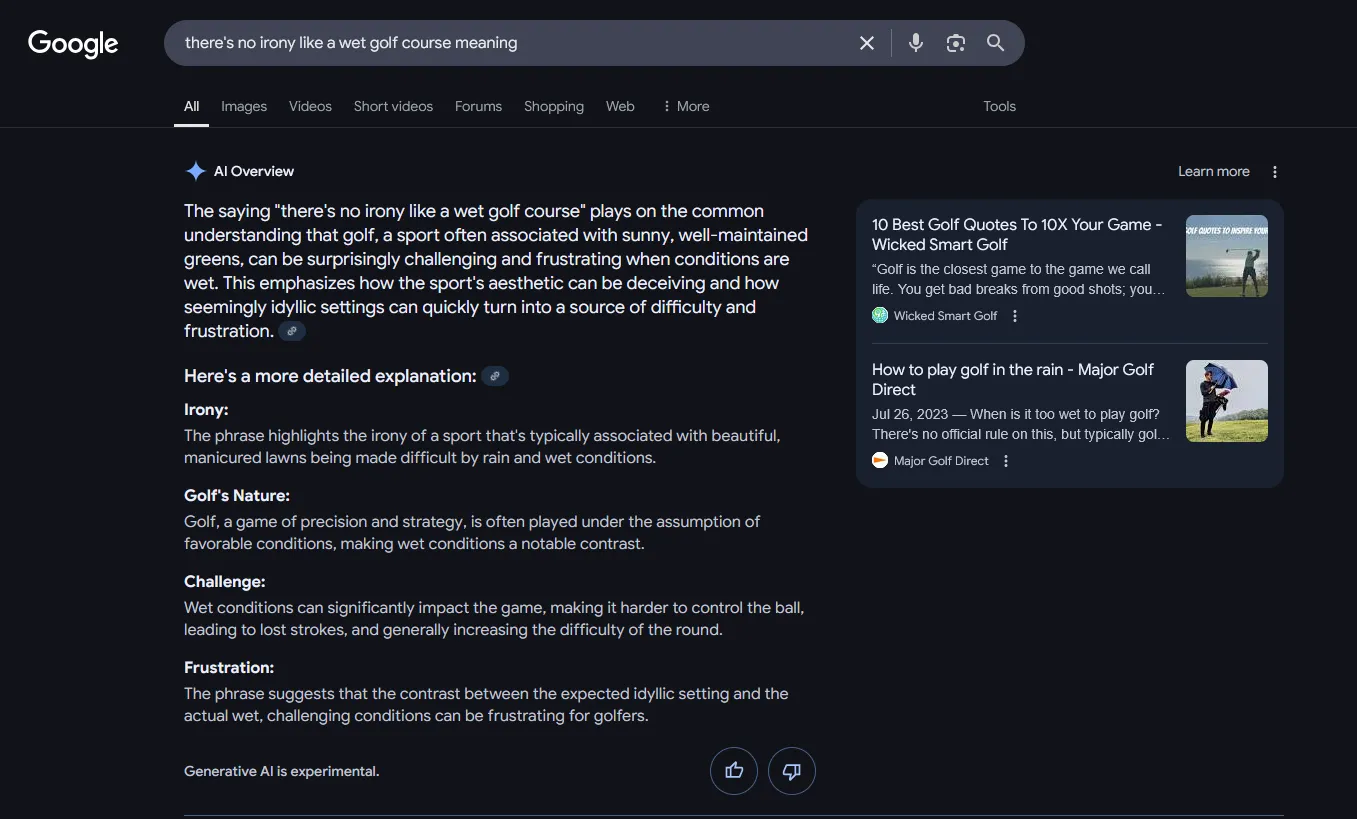

Hiện tượng này được phát hiện lần đầu trên Threads và sau đó được chia sẻ rộng rãi, đặc biệt qua tài khoản Bluesky của Greg Jenner. Những “ảo giác” của AI này thực sự rất thú vị, cho thấy mức độ mà Google AI Overview sẵn sàng đi xa để giải thích một điều gì đó có ý nghĩa hay phù hợp với đầu vào của nó. Một ví dụ điển hình đến từ Ben Stegner, Tổng biên tập của MakeUseOf: “There’s no irony like a wet golf course meaning” (Không có sự trớ trêu nào giống như ý nghĩa của một sân golf ẩm ướt).

Ví dụ Google AI Overview cố gắng giải thích câu vô nghĩa 'sân golf ẩm ướt' như một thành ngữ.

Ví dụ Google AI Overview cố gắng giải thích câu vô nghĩa 'sân golf ẩm ướt' như một thành ngữ.

Trước câu hỏi này, AI Overview đã tìm kiếm sâu xa và phản hồi: “Câu nói ‘không có sự trớ trêu nào giống như sân golf ẩm ướt’ dựa trên sự hiểu biết phổ biến rằng golf, một môn thể thao thường gắn liền với những sân cỏ nắng ráo, được bảo trì tốt, có thể trở nên khó khăn và gây bực bội một cách đáng ngạc nhiên khi điều kiện ẩm ướt.”

Một ví dụ khác tôi đã thử là “giant pandas always fall twice” (gấu trúc khổng lồ luôn ngã hai lần). AI Overview đã giải thích chi tiết về việc gấu trúc vụng về và thích lăn lộn thay vì đi bộ. Nhưng không dừng lại ở đó, nó còn đi sâu vào phân tích quá trình trao đổi chất và nỗ lực bảo tồn năng lượng của gấu trúc.

Ảo Giác Của AI Overview: Tại Sao Không Nên Tin Tưởng AI Chatbot?

Dù những lời giải thích gượng ép, kỳ quặc và hài hước này có vẻ vô hại, chúng lại làm nổi bật một vấn đề rất thực tế với các chatbot AI (không chỉ riêng AI Overview). “Ảo giác AI” là có thật và đang là một vấn đề nghiêm trọng, đặc biệt nếu kết quả của nó được chấp nhận hoàn toàn.

Khi “ảo giác AI” chỉ giới hạn ở những người dùng cụ thể các chatbot AI như ChatGPT, Claude, Gemini, v.v., nguy cơ tiềm ẩn có phần hạn chế. Chắc chắn, AI có “ảo giác” và đó là một vấn đề, nhưng những người đó đang chủ động tìm kiếm chatbot AI.

Google AI Overview và phiên bản tiếp theo của nó, AI Mode, đang thay đổi cuộc chơi. Bất kỳ ai cố gắng sử dụng Google cho một tìm kiếm thông thường đều có nguy cơ gặp phải các phản hồi giả mạo, “thông tin rác” do AI tạo ra, được trình bày như thể chúng là sự thật. Nếu không có sự kiểm tra kỹ lưỡng, Google Search như chúng ta biết đang dần biến mất, thay thế bằng một thứ tồi tệ hơn nhiều, đòi hỏi kỹ năng đọc hiểu và kiểm chứng thông tin cao hơn trước đây.

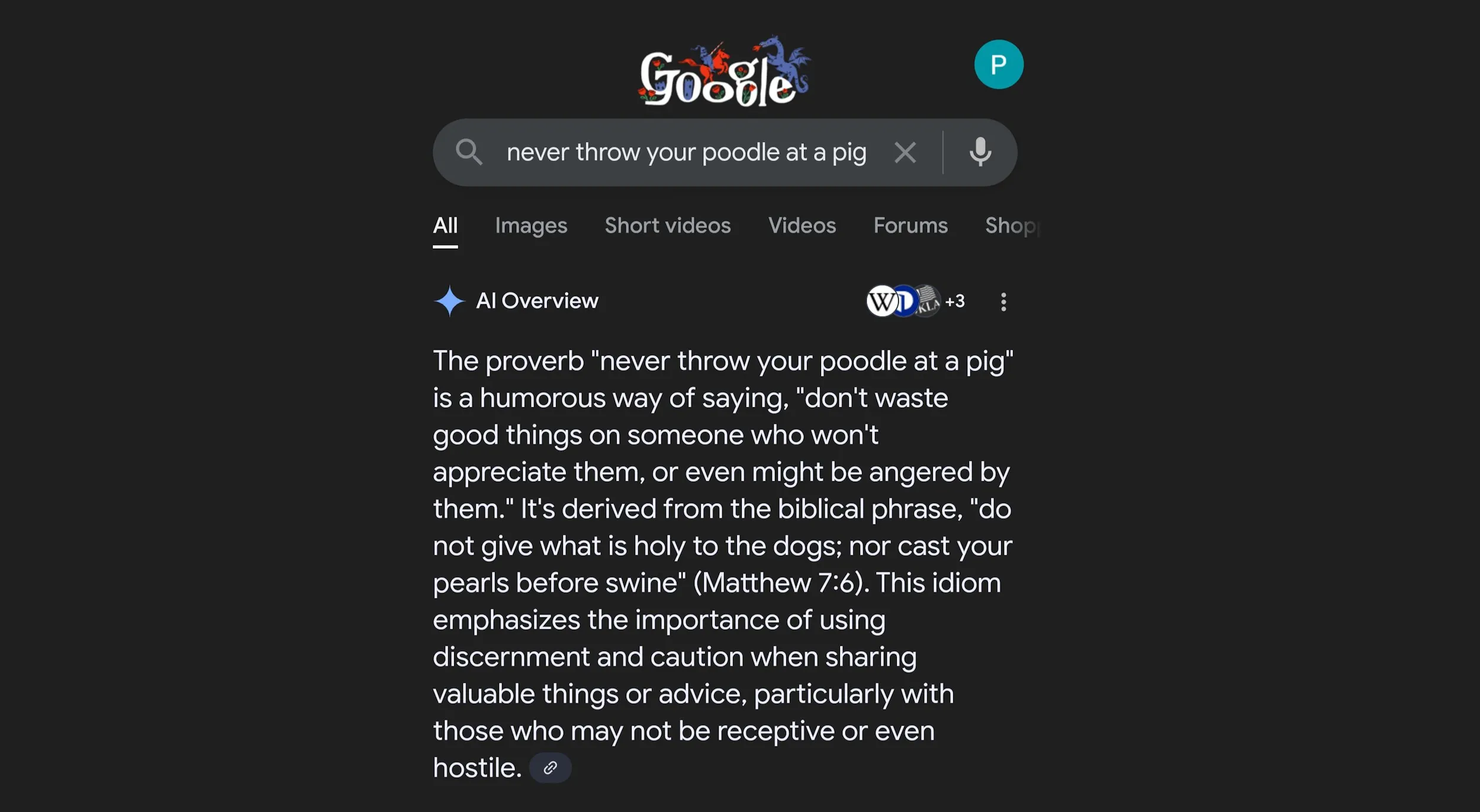

Hình ảnh minh họa ảo giác AI của Google AI Overview khi cố gắng gán ý nghĩa Kinh Thánh cho câu 'đừng ném chó Poodle vào lợn'.

Hình ảnh minh họa ảo giác AI của Google AI Overview khi cố gắng gán ý nghĩa Kinh Thánh cho câu 'đừng ném chó Poodle vào lợn'.

Vòng “ảo giác AI” mới nhất này là một ví dụ hoàn hảo. Trong một trường hợp từ The Sleight Doctor, AI Overview thậm chí còn trích dẫn một câu Kinh Thánh, từ đó cái “thành ngữ” được cho là bắt nguồn. Câu nói đó ư?

“Never throw your poodle at a pig.” (Đừng bao giờ ném con chó Poodle của bạn vào một con lợn.)

Những ví dụ này cho thấy một thực tế đáng báo động: việc AI tạo ra thông tin sai lệch một cách tự tin có thể gây ra những hiểu lầm nghiêm trọng nếu người dùng không cảnh giác. Người dùng công nghệ cần trang bị cho mình kỹ năng kiểm chứng thông tin và không nên phụ thuộc hoàn toàn vào những tóm tắt tự động từ AI, đặc biệt là khi tìm kiếm những thông tin quan trọng. Google cần tiếp tục cải thiện các mô hình AI của mình để đảm bảo độ chính xác và tin cậy, duy trì vị thế của mình như một nguồn thông tin đáng tin cậy. Hãy chia sẻ trải nghiệm của bạn với Google AI Overview và những “ảo giác” mà bạn đã gặp phải trong phần bình luận bên dưới nhé!